En palabras de la Unión Europea, la distribución de imágenes y videos de abuso sexual infantil, que ha aumentado dramáticamente con el desarrollo del mundo digital, permite crear "soluciones" donde el control de todas nuestras actividades digitales es aceptable.

Aunque el daño sufrido por las víctimas es infinito y los perpetradores han encontrado nuevos caminos a través de servicios digitales para acceder y explotar a niños y proveedores de servicios de hospedaje o comunicación interpersonal, nuestra privacidad e intimidad son un derecho humano fundamental.

Las autoridades públicas de todo el mundo quieren hacernos creer que su política de vigilancia es un comportamiento responsable y cuidadoso, esencial para un entorno en línea seguro, predecible y de confianza, así como para el ejercicio de los derechos fundamentales garantizados. En el Reino Unido, los funcionarios del gobierno han expresado durante años preocupaciones de que los servicios en línea no están haciendo lo suficiente contra el contenido ilegal, especialmente sobre material de abuso sexual infantil.

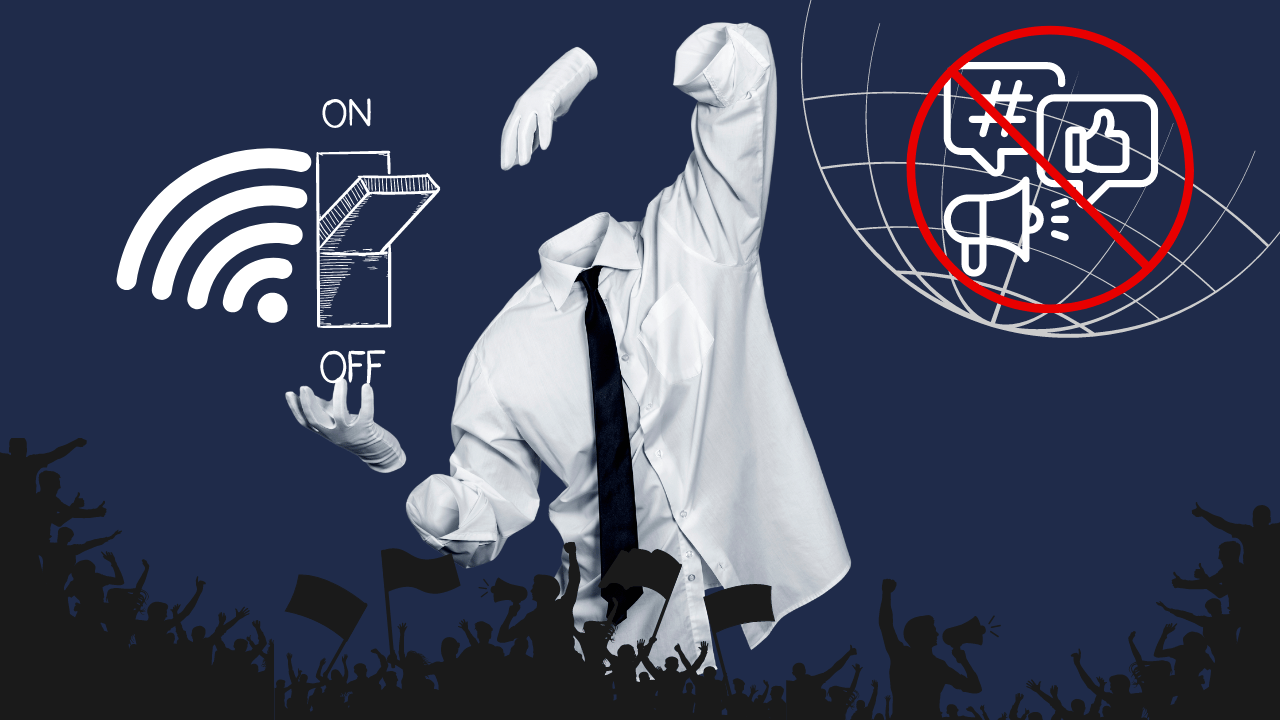

La “solución” fue el Online Safety Bill, con el que el Reino Unido supuestamente se convertirá en el lugar más seguro del mundo para usar Internet. Pero no te preocupes, esta terrible ley no solo afecta al Reino Unido, es una hoja de ruta para la opresión en todo el mundo. Los defensores de la ley señalan el peor contenido en línea, como publicaciones terroristas y abuso infantil, pero la vigilancia no terminará ahí.

Se obligará a las empresas a monitorear otras categorías de contenido e intercambiar información sobre los usuarios entre diferentes países. Periodistas y activistas de derechos humanos serán inevitablemente el objetivo. Y los usuarios nunca podrán estar seguros de si sus mensajes privados están siendo leídos e interceptados por empresas privadas.

Apple siempre un paso por delante en colaboración con gobiernos

En agosto de 2021, Apple anunció un plan para verificar las fotos que los usuarios almacenan en iCloud en busca de material de abuso sexual infantil (CSAM). La herramienta debía proteger la privacidad y permitir que la empresa señalara contenido potencialmente problemático y abusivo sin revelar nada más.

Sin embargo, la iniciativa fue controvertida y pronto atrajo fuertes críticas de investigadores de privacidad y seguridad, así como de grupos de derechos digitales, que temían que la misma función de vigilancia pudiera ser abusada para socavar la privacidad y seguridad de los usuarios de iCloud en todo el mundo. A principios de septiembre de 2021, Apple anunció que pausaría el lanzamiento de la función para “recibir sugerencias y realizar mejoras antes de que se publiquen estas importantes funciones de seguridad infantil”.

En otras palabras, el lanzamiento vendrá más tarde. Ahora la empresa dice que la herramienta de detección de CSAM para fotos de iCloud ya no está disponible debido a los comentarios y opiniones recibidos.

En cambio, Apple explicó esta semana a WIRED que la empresa está enfocando sus esfuerzos e inversiones en combatir CSAM en sus funciones de “seguridad de comunicación”, que anunció en agosto de 2021 e implementó en diciembre del año pasado. Los padres y tutores pueden optar por protección a través de las cuentas familiares de iCloud. Las funciones funcionan en Siri, la búsqueda Spotlight de Apple y la búsqueda de Safari para advertir cuando alguien está viendo o buscando material de abuso infantil, y proporcionar recursos in situ para informar el contenido y buscar ayuda.

Al igual que los adultos, los niños confían en aplicaciones de comunicación encriptada como WhatsApp o Signal, y tienen todo el derecho a esperar que no estarán sujetos a verificaciones de identidad obligatorias, filtros arbitrarios y vigilancia. Sobre todo, los niños maltratados necesitan canales privados y seguros para informar sobre lo que les ha sucedido. El proyecto de ley está destinado a proteger a los niños, pero ignora su privacidad y pasa por alto principios internacionalmente reconocidos sobre los derechos de los niños.

Sin embargo, al Parlamento no le importó. Aún peor es que el Reino Unido no está solo: dado que el público no puede apoyar la idea de que la policía escanee cada mensaje digital, los legisladores en otras democracias liberales también han recurrido a soluciones de evasión, alegando que las puertas traseras en la encriptación son necesarias para investigar archivos de los peores crímenes. Han afirmado incorrectamente que ciertos métodos para verificar archivos y mensajes de usuarios, como el escaneo del lado del cliente, no rompen la encriptación en absoluto.

Las autoridades también han intentado -y afortunadamente han fallado- presionar a Apple para que introduzca un sistema de escáneres de software en cada dispositivo que busque constantemente imágenes de abuso infantil e informe a las autoridades.

Para gestionar a los ciudadanos, los estados operan vigilancia, es decir, la recopilación y almacenamiento sistemático de

datos personales “para proteger, comprender, atender, controlar, gestionar o

influir en individuos o grupos”. A través de sus sistemas de bienestar social y aplicación de la ley,

el estado recopila amplia información sobre la población e identifica grupos marginados.

Como vimos en el caso Epstein, la trata de niños y el abuso infantil pudieron ser gestionados y concentrados en personalidades de alto perfil durante años, incluso involucrando a políticos, por lo que estas leyes en este caso se relacionan más con la noción de Foucault de un solo inspector central y omnisciente que, en cambio, conceptualiza una “asamblea supervisora” que integra información a través de sistemas. En este concepto, las capacidades modernas de almacenamiento y fusión de datos reúnen sistemas anteriormente separados, lo que resulta en una vigilancia cada vez más fluida y completa.

No hay término medio, ni una “puerta trasera segura”, si la Internet debe permanecer libre y privada. Puede que ya sea demasiado tarde para detener estos desarrollos. La lucha contra el CSAM es un esfuerzo complicado y matizado, con mucho en juego para los niños de todo el mundo, y aún es incierto cuánta tracción obtendrán las grandes empresas tecnológicas que apuestan por una intervención proactiva. Pero los gigantes tecnológicos caminan una delgada línea al equilibrar la detección de CSAM con la privacidad de los usuarios.

La importancia de prevenir y combatir el abuso infantil no debe ser una excusa para introducir programas de vigilancia masiva. Los estados deben encontrar soluciones que mantengan la información personal, la comunicación y los dispositivos de los ciudadanos privados, pero como la experiencia nos ha enseñado repetidamente que no podemos confiar en los gobiernos en este asunto, existe PRVCY World desde el principio.