Estos sistemas, a menudo denominados “instrumentos de evaluación de riesgo“, se utilizan para decidir si se debe liberar a los acusados antes del juicio, si investigar acusaciones de negligencia infantil, para predecir qué estudiantes podrían abandonar la escuela, entre otras cosas.

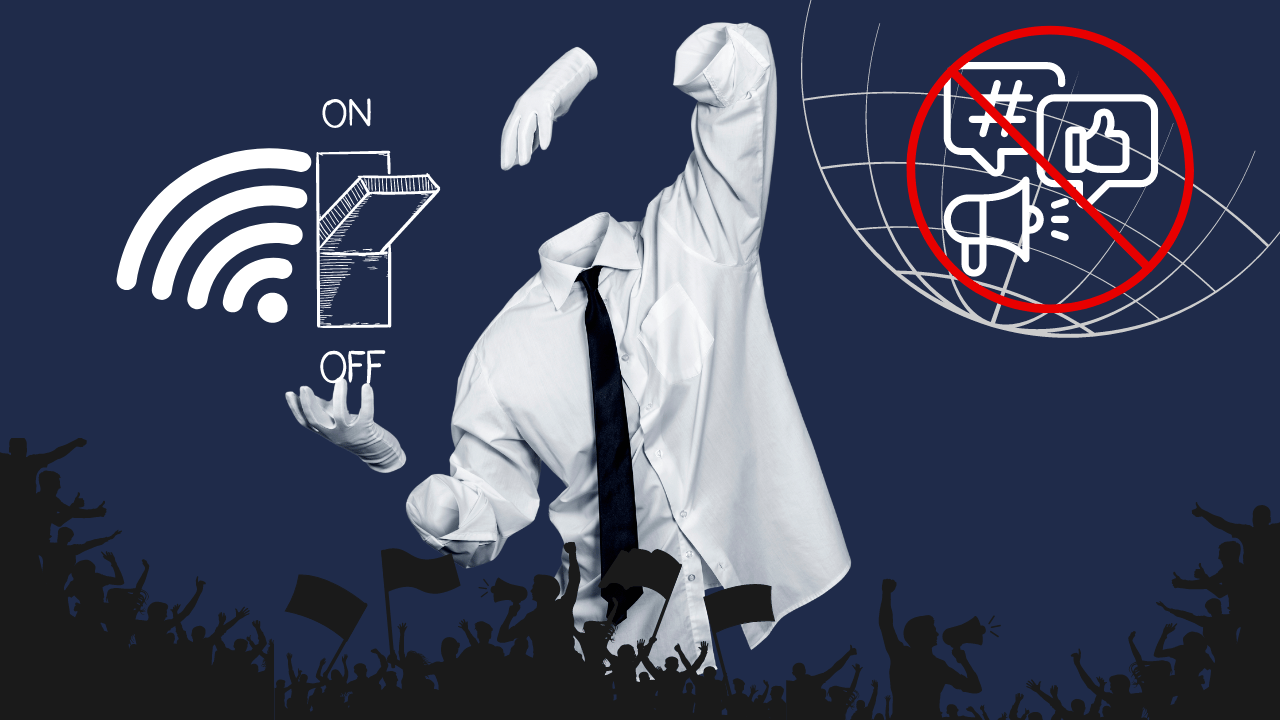

El aprendizaje automático (ML) penetra cada vez más en todas las áreas de la vida. Desafíos sociales y políticos complejos, contextuales y en constante cambio son automatizados y convertidos en problemas matemáticos y técnicos. Al mismo tiempo, la investigación sobre la injusticia algorítmica muestra cómo el ML automatiza y perpetúa patrones históricos, a menudo injustos y discriminatorios. Las consecuencias negativas de los sistemas algorítmicos, especialmente para las poblaciones marginadas, han impulsado el trabajo hacia la equidad algorítmica.

Muchos de los sistemas utilizados hoy en día se basan en grandes cantidades de datos históricos y modelos de aprendizaje automático que predicen el comportamiento futuro y el éxito de los participantes del sistema. Por ejemplo, Microsoft utiliza dichos modelos para evaluar las habilidades de los jugadores en juegos en línea, los bancos juzgan la confiabilidad de posibles prestatarios cuando solicitan un préstamo, y algunas empresas incluso han intentado automatizar la revisión de currículums para puestos vacantes. En estas situaciones, los desarrolladores confían en los algoritmos.

Sin embargo, la mayoría de estos trabajos están muy enfocados y se centran en el ajuste fino de ciertos modelos, la mejora de la representatividad de los conjuntos de datos y la “mitigación” de los conjuntos de datos. Aunque tales medidas pueden representar una parte de la solución, un enfoque fundamentalmente justo debe considerar el panorama general, como presunciones no cuestionadas o intuitivas en los conjuntos de datos, injusticias actuales e históricas y asimetrías de poder.

Los desarrolladores de estas herramientas y las autoridades que las utilizan a menudo afirman que las evaluaciones de riesgo mejorarán las decisiones humanas mediante el uso de datos. Pero los instrumentos de evaluación de riesgo (y los datos utilizados para crearlos) no son solo sistemas técnicos que existen de manera aislada, están intrínsecamente entrelazados con la política de los sistemas en los que se implementan y pueden reproducir los sesgos de estos sistemas. Queremos esclarecer el concepto de herramientas de evaluación de riesgo y explorar ejemplos prácticos de su aplicación.

1. Programas de asistencia social:

Una de las aplicaciones más comunes de los instrumentos de evaluación de riesgo es determinar la elegibilidad para los programas de asistencia social. Por ejemplo, los gobiernos recopilan datos sobre ingresos, estado laboral y tamaño familiar para decidir si una familia tiene derecho a asistencia alimentaria o beneficios de desempleo. Al analizar estos datos, buscan garantizar que quienes realmente necesitan ayuda la reciban.

2. Asignación de servicios de salud:

En el ámbito sanitario, los gobiernos utilizan registros médicos personales y datos de salud para distribuir recursos de manera eficiente. Esta estrategia se utilizó, por ejemplo, durante la pandemia para identificar y priorizar a los grupos destinatarios para la vacunación.

3. Sistema de justicia penal:

Los instrumentos de evaluación de riesgo también han entrado en el sistema de justicia penal. Analizan el historial criminal y el contexto de una persona para evaluar el riesgo de reincidencia. Los resultados pueden influir en las decisiones sobre la cantidad de fianza o la sentencia, para alcanzar un enfoque más justo y basado en evidencia en la justicia.

4. Educación:

En el ámbito educativo, los datos juegan un papel crucial en la asignación de recursos y el análisis demográfico. El sistema educativo es uno de los lugares más sencillos para recopilar datos, ya que en la mayoría de los países la asistencia escolar es obligatoria. Del sistema educativo, los gobiernos obtienen información sobre las finanzas, las condiciones familiares, el lugar de residencia, así como la salud mental y física.

5. Impuestos:

La recaudación de impuestos es otro ámbito donde entran en juego los datos financieros personales. Los gobiernos utilizan datos sobre ingresos y propiedades para determinar la cantidad de impuesto sobre la propiedad que una persona debe pagar.

6. Salud pública:

En el contexto de la salud pública, los datos recolectados de varias fuentes como aplicaciones móviles y dispositivos portátiles ayudan a monitorear la salud de la población. Esto permite incluso a las compañías de seguros hacer predicciones y estimaciones sobre riesgos y complicaciones futuras para la salud de una persona.

7. Subsidios de vivienda:

Los gobiernos utilizan datos financieros personales y de vivienda para determinar la elegibilidad para los programas de subsidios de vivienda. La información sobre ingresos, tamaño familiar y condiciones de vivienda asegura que quienes necesitan una vivienda asequible reciban el apoyo necesario.

8. Inmigración:

Las autoridades de inmigración se basan en datos personales para tomar decisiones sobre la concesión de visados y deportaciones. Factores como el historial de viajes, el registro penal y el estado laboral se consideran en las decisiones de inmigración.

9. Protección civil:

En caso de desastres naturales, los gobiernos recopilan datos sobre la población afectada para utilizar sus recursos de manera eficaz. Por ejemplo, se utilizan datos de ubicación para identificar áreas que necesitan ayuda inmediata, ayudando así en la rápida respuesta de socorro.

¿Por qué es esto importante para el mundo de PRVCY?

Porque la posesión de todos esos datos a veces incita a los gobiernos a volverse codiciosos y a intentar controlar nuestra vida personal, como vimos durante la plandemia.

Aunque las herramientas de evaluación de riesgos son, sin duda, prometedoras para una mejor gobernanza, la privacidad de los datos, la equidad y los posibles sesgos en estos sistemas son omnipresentes. Encontrar el equilibrio correcto entre usar los datos para el bien común y proteger los derechos individuales es un desafío constante para los gobiernos de todo el mundo, y no lo hacen particularmente bien.

En los Estados Unidos, se usó PATTERN para tomar decisiones sobre si las personas encarceladas debían ser liberadas de prisión y colocadas en arresto domiciliario al estallar la pandemia de COVID-19.

PATTERN emite “puntuaciones de riesgo”, esencialmente números que estiman qué tan probable es que una persona sea arrestada o encarcelada nuevamente después de su liberación. A través de umbrales, estas puntuaciones se convierten en categorías de riesgo. Por ejemplo, una puntuación por debajo de un cierto valor podría considerarse de “bajo riesgo”, mientras que puntuaciones en o por encima de ese valor se clasificarían como “alto riesgo” y así sucesivamente.

Expertos en PRVCY digital llaman a este sistema una injusticia algorítmica.

La IA se basa en algoritmos de aprendizaje automático que, aunque son alabados como una solución versátil en la industria tecnológica, también tienen sus debilidades. Como cualquier otro sistema informático, son propensos a errores.

En el ámbito de la ciberseguridad, por ejemplo, se utilizan algoritmos de aprendizaje automático para identificar rápidamente software malicioso previamente desconocido. Sin embargo, esto crea un dilema: cuanto mayor sea la tasa de detección, mayor será la probabilidad de que el sistema clasifique erróneamente un archivo no malicioso como malicioso. Esto se debe al funcionamiento básico del aprendizaje automático, donde el sistema no examina las peculiaridades de un objeto, sino que compara sus características visuales con las de objetos conocidos.

En ciertos escenarios, los objetos benignos pueden parecerse mucho a objetos maliciosos, y un sistema basado en puntuaciones probablemente clasificaría el objeto como malicioso. En un contexto donde los sistemas automatizados evalúan el comportamiento humano, este aspecto particular de los sistemas de aprendizaje automático puede llevar a numerosas situaciones incómodas donde una persona inocente se ve involucrada erróneamente en acciones “incorrectas”.

En otros ejemplos, los gobiernos utilizan la recolección de datos de una manera que ni siquiera sabemos para qué sirve.

En 2020, la presidencia de Costa Rica se vio envuelta en turbulencias significativas cuando los investigadores federales llevaron a cabo registros en las oficinas del presidente y se destituyó a cuatro personalidades prominentes, incluido el mentor y principal colaborador del presidente. En el centro de esta agitación estaba un departamento de análisis de datos establecido en las oficinas ejecutivas, que en los 18 meses anteriores había recopilado y evaluado datos personales privados de diversas fuentes gubernamentales, supuestamente para ayudar en el diseño de políticas públicas. La cuestión clave fue el hecho de que el departamento de análisis de datos del presidente no tenía una base legal hasta que el gobierno emitió un decreto el 19 de febrero autorizando su creación y confiriéndole la autoridad para solicitar datos personales confidenciales de otras agencias gubernamentales.

¿Cómo podemos asegurar que las agencias gubernamentales y otros tomadores de decisiones sean responsables del daño potencial que los instrumentos de evaluación de riesgos pueden causar?

Estos sistemas son propensos a problemas como el sesgo del desarrollador, correlaciones erróneas y ciclos de retroalimentación, y los algoritmos no consideran consideraciones éticas a menos que el desarrollador las haya incorporado explícitamente. Simplemente ingresar grandes cantidades de información en un sistema de aprendizaje automático y luego aceptar el resultado sin escrutinio crítico puede conducir a una variedad de consecuencias no intencionadas, incluidas decisiones que en última instancia violan los derechos de ciertos ciudadanos.

En Europa y América, actualmente se están desarrollando leyes que obligan a las empresas a proporcionar a las personas información comprensible sobre por qué su puntuación ha mejorado o empeorado (ECOA 1974, GDPR 2016) para que la automatización no se convierta en una prueba de caja negra (el evaluador sabe lo que el software debería hacer, pero no cómo). Sin embargo, esto no ocurre en todos los demás países que consideran la implementación de un sistema de evaluación social en el futuro, al menos según la información que pudimos encontrar en fuentes públicas. Si esto es correcto, significa que una gran variedad de decisiones puede quedar completamente en manos de la IA, lo cual es problemático.

Su capacidad para cambiar las reglas de funcionamiento del sistema puede influir significativamente en la vida de aquellos grupos sociales que no pueden influir en las reglas de evaluación. Para impulsar este cambio, hemos creado un recurso para que te sientas capacitado para preguntar cuando las autoridades gubernamentales o desarrolladores hagan afirmaciones sobre herramientas de evaluación de riesgos.

La mayoría de estos sistemas se basa en una interfaz de acceso público que contiene grandes cantidades de datos personales, incluidas todas las “infracciones” cometidas. Este tipo de interfaz es más susceptible a filtraciones y, si se accede ilegalmente, puede tener terribles consecuencias para las personas atacadas. Tampoco necesita ser hackeada. Las instituciones que utilizan tales sistemas a menudo proporcionan API que permiten acceder a las diversas infracciones de una persona introduciendo información como su número de teléfono o pasaporte.

¿Se convertirá nuestra realidad en general en una especie de futuro distópico basado en el aprendizaje automático para tomar decisiones?

Aún no, pero probablemente sí. Todavía hay demasiadas incógnitas, y no está claro si se podrán implementar sistemas a nivel nacional en países con formas de gobierno y marcos legales tan diversos.

Como ciudadanos, es importante estar informados sobre cómo se utilizan nuestros datos y abogar por la transparencia y la equidad en estos sistemas. Al final, el poder de los datos no reside solo en su recopilación, sino también en su uso responsable y ético.

Sin embargo, una cosa está clara: a medida que la tecnología continúa avanzando sin restricciones, los límites entre la tecnología digital y los temas sociales y políticos más amplios solo se difuminarán más. Por eso mi #PRVCYConsejos: